خزنده های گوگل که به آن ها Crawler هم گفته میشود، برنامه هایی خودکار هستند که وظیفه شان بررسی (Crawl) و فهرستبندی (Index) صفحات وب در اینترنت است. برای آشنایی بیشتر و دریافت اطلاعات کامل تر، همراه ما در وب سایت سئو ایرانی باشید.

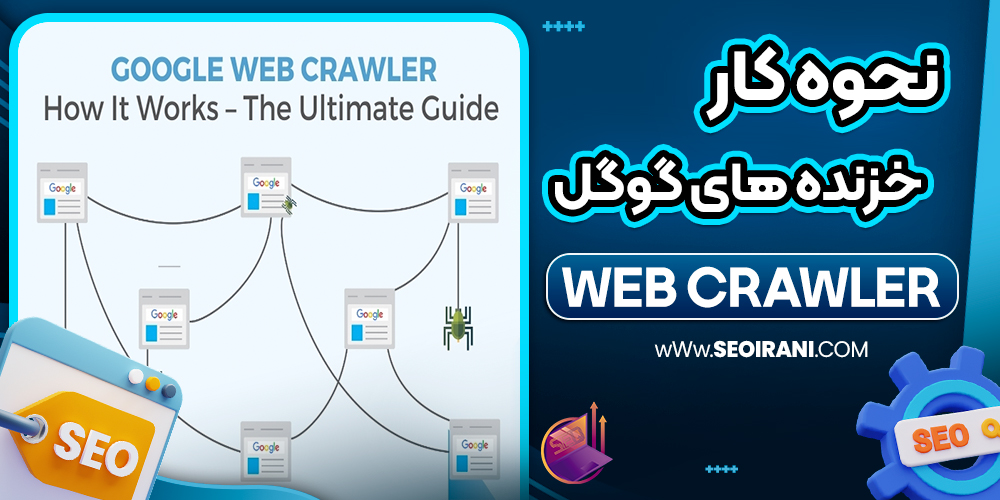

Crawling یا خزیدن در وب

Crawling یا خزیدن، به فرآیند خودکار بازدید از صفحات وب توسط برنامههایی به نام خزنده (Crawler یا Spider) گفته میشود. این برنامهها با هدف جمعآوری اطلاعات از وبسایتها طراحی شدهاند و نقش بسیار مهمی در عملکرد موتورهای جستجو ایفا میکنند. خزندهها بدون دخالت انسان، میلیونها صفحه را بررسی کرده و دادهها را برای پردازشهای بعدی ذخیره میکنند.

هدف اصلی Crawling یا خزیدن در وب

هدف اصلی خزیدن در وب، دسترسی به اطلاعات موجود در صفحات مختلف و آمادهسازی آنها برای تحلیل، ذخیرهسازی یا نمایهسازی است. به عنوان مثال، موتور جستجوی گوگل باید بداند هر صفحه در وب چه محتوایی دارد تا بتواند آن را در نتایج جستجو نمایش دهد. علاوه بر موتورهای جستجو، شرکتها و برنامهنویسان از Crawling برای استخراج قیمت محصولات، اخبار، مقالات یا حتی تحلیل شبکههای اجتماعی استفاده میکنند.

نحوه کار Crawler یا خزنده

خزندهها ابتدا کار خود را با یک لیست از URLهای اولیه آغاز میکنند، به آنها سر میزنند و محتوای صفحات را ذخیره میکنند. سپس در کد HTML این صفحات جستجو کرده و لینکهایی که به صفحات دیگر اشاره دارند را شناسایی میکنند. این لینکها به صف پردازش خزنده افزوده میشوند و این روند تا زمانی که همه صفحات بازدید شوند یا محدودیت زمانی/تعداد اعمال شود، ادامه پیدا میکند.

web crawler چه ویژگی هایی دارد؟

Web Crawler ها باید بسیار سریع و بهینه باشند، زیرا با میلیون ها صفحه در اینترنت سر و کار دارند. آن ها همچنین باید به فایل هایی مثل robots.txt احترام بگذارند تا قوانین هر سایت را رعایت کنند. بعضی خزندهها به صورت عمومی کار میکنند (مثل Googlebot)، و برخی دیگر خصوصی هستند و فقط برای اهداف خاص (مثل پایش قیمت یا مانیتورینگ محتوا) طراحی شدهاند.

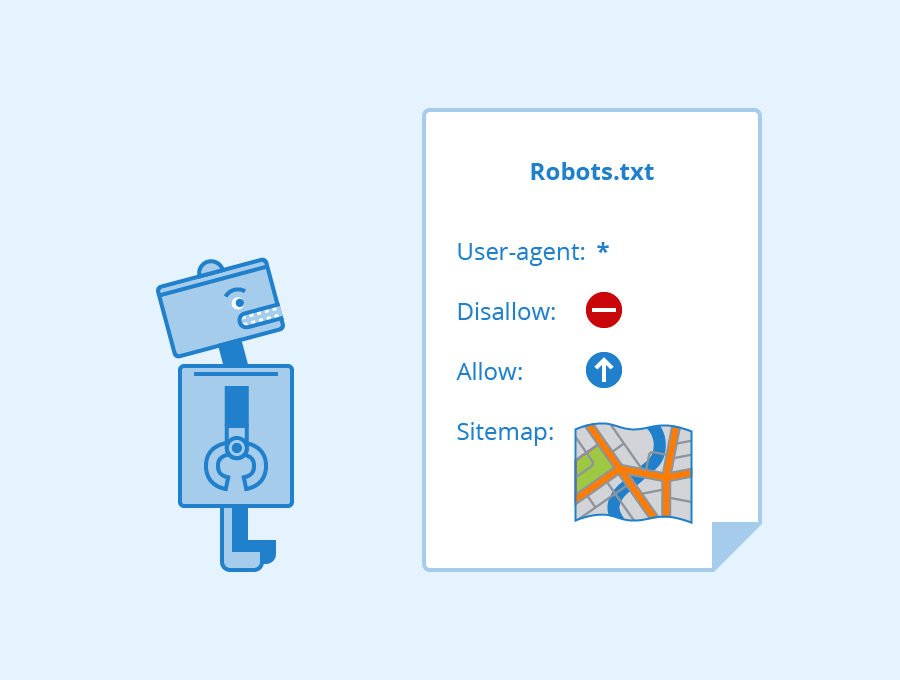

فایل robots.txt چیست؟

فایل robots.txt یک فایل متنی ساده است که در ریشهی یک وبسایت قرار میگیرد (مثلاً example.com/robots.txt) و به خزندههای وب (Web Crawlers) میگوید که کدام بخشهای سایت را اجازه دارند بخزند (crawl) و کدام بخشها را نه. این فایل، بخشی از استاندارد معروف به “پروتکل محرومسازی رباتها” (Robots Exclusion Protocol) است.

کاربرد فایل robots.txt در خزیدن

این فایل توسط مدیران وبسایتها ایجاد میشود تا نحوهی رفتار خزندهها (مثل Googlebot یا Bingbot) را کنترل کنند. بهنوعی یک دستور راهنما برای رباتها است که مشخص میکند آنها کجاها اجازه ورود دارند و از کجاها باید دوری کنند. این کار بهخصوص زمانی مفید است که نمیخواهید صفحات خاصی (مثل صفحات مدیریت، اطلاعات خصوصی یا نسخههای موقتی) توسط موتورهای جستجو دیده و فهرست شوند.

کاربرد اصلی Crawling یا خزیدن در وب

یکی از رایجترین کاربردهای Crawling، استفاده از آن در موتورهای جستجو است که اطلاعات سایتها را برای نمایش در نتایج جستجو جمعآوری میکنند. همچنین در زمینهی دادهکاوی و استخراج اطلاعات خاص مانند قیمت کالا، مشخصات محصول یا تحلیل رقبا نیز کاربرد دارد. در صنعت سئو (SEO)، خزندهها برای بررسی ساختار سایت، لینکها، و وضعیت بهینهسازی صفحات مورد استفاده قرار میگیرند.

قوانین خزیدن و احترام به سایت ها

برای اینکه خزندهها به سایتها آسیب نزنند یا باعث ترافیک اضافی نشوند، باید از فایل robots.txt پیروی کنند. این فایل در ریشهی سایت قرار میگیرد و مشخص میکند کدام قسمتها برای خزندهها باز و کدام بسته هستند. رعایت این قوانین باعث میشود تعامل میان وبسایتها و خزندهها منظم و محترمانه باقی بماند، بدون اینکه به سرور سایت آسیب برسد.

ابزار های معروف Crawling یا خزیدن

ابزارهایی مانند Googlebot به طور گسترده توسط گوگل برای جمعآوری و نمایهسازی اطلاعات سایتها استفاده میشوند. ابزار Screaming Frog یکی از محبوبترین نرمافزارهای تحلیل سئو است که سایتها را شبیه به یک خزنده بررسی میکند. اگر با برنامهنویسی آشنا باشید، ابزارهایی مثل Scrapy یا BeautifulSoup در زبان پایتون، امکانات پیشرفتهای برای خزیدن و استخراج داده به شما میدهند.

تفاوت Crawling و Scraping

در حالی که Crawling روی مرور و جمعآوری ساختار صفحات وب تمرکز دارد، Web Scraping روی استخراج دقیق دادههای خاص مثل قیمت، عنوان، تصویر یا توضیحات محصول تمرکز میکند. در واقع، Scraping مرحلهی بعدی پس از Crawling محسوب میشود، جایی که از دادههای جمعآوریشده استفاده عملی میشود. همچنین از نظر اخلاقی و قانونی، Scraping حساستر از Crawling است، چون معمولاً دادههای دقیق و حساس استخراج میشوند.

Indexing یا فهرستبندی اطلاعات

پس از خزیدن یک صفحه، نوبت به نمایه سازی یا Indexing میرسد. در این مرحله، اطلاعات جمع آوریشده از صفحه، تجزیه و تحلیل، دسته بندی و ذخیره می شود. گوگل یا سایر موتورهای جستجو مشخص میکنند که محتوای صفحه دربارهی چیست، چه کلیدواژه هایی دارد، ساختار صفحه چگونه است و آیا ارزش ذخیره سازی دارد یا نه.

فقط صفحاتی که نمایه سازی شده اند، امکان نمایش در نتایج جستجو را دارند. اگر نمایه سازی صورت نگیرد، حتی اگر صفحه خزیده شده باشد، در نتایج ظاهر نخواهد شد.

Ranking و رتبهبندی در نتایج جستجو گوگل

Ranking آخرین مرحله است، یعنی بعد از اینکه صفحهای خزیده و نمایه سازی شد، حالا در نتایج جستجو باید رتبهای مشخص به آن اختصاص داده شود. این رتبه بر اساس صدها فاکتور مثل کیفیت محتوا، سرعت سایت، تعداد و کیفیت لینک های ورودی، رفتار کاربران، و… تعیین می شود.

هدف رتبه بندی این است که مربوط ترین و بهترین صفحات برای یک جستجوی خاص در بالاترین جایگاه ها قرار بگیرند. بنابراین هر چه صفحه ای بهتر باشد، احتمال قرار گرفتن در رتبه ۱ بیشتر است.

⏬مقالات پیشنهادی برای شما عزیزان⏬

موتور های جست و جو چیستمعرفی ابزار Google Trends برای تولید محتواسئو در یوتیوب

سئو ایرانی SeoIrani | سئو چست و آموزش صفر تا صد سئو رایگان

سئو ایرانی SeoIrani | سئو چست و آموزش صفر تا صد سئو رایگان